你听说过ChatGPT吗?

相信在前一段时间的宣传浪潮之下,大家或多或少都听说过ChatGPT的名号。在众多科技博主的宣传中,它拥有着接近于人类的对话能力而且似乎无所不知,刷新了人们对人工智能总是冷冰冰的看法。

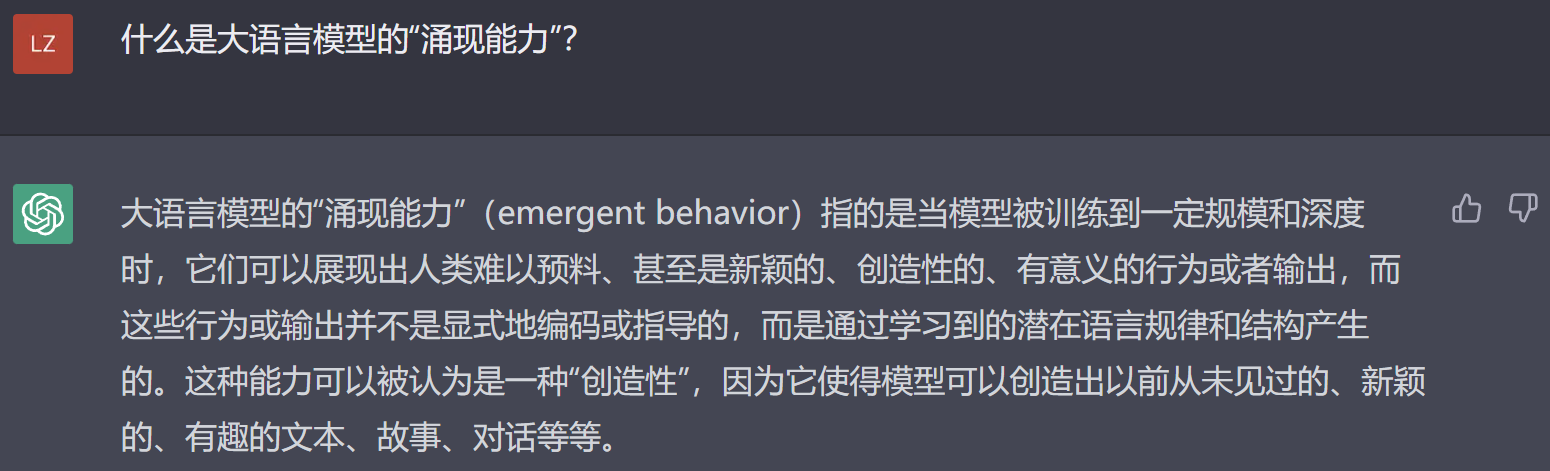

ChatGPT的能力从图中这位网友与ChatGPT的对话就可以窥知一二。从这段对话我们可以发现ChatGPT能够“理解”自然语言(一种自然地随文化演化的语言,如汉语、英语),认识到其中的数学问题并给出正确的解答。不仅如此,ChatGPT还是一个不错的“倾听者”。在这位网友问出第二个问题时,ChatGPT能够意识到这句话应该和先前的问题关联在一起并根据语境给出回答。更让人觉得奇妙的是,ChatGPT在面对网友看似捣乱的两次补充叙述时,先是能在数学的角度坚持自己的答案,而后又能从新的对话内容中“意识到”自己知识的局限性并接受了网友对答案的“纠正”。从中我们可以感受到,ChatGPT好像是“通人性”的。

图1 ChatGPT与网友的对话

什么?你说这是你第一次听说ChatGPT?那你可得更加仔细地听我介绍了。

接下来的内容主要分为四个部分。首先在第一部分,我会先介绍ChatGPT背后的原理,掀开其神秘面纱的一角。而后在第二部分,我会简要介绍OpenAI公司以及ChatGPT的发展历程,从更为宏观的角度介绍GPT的发展。在第三部分,我会从用户个人的角度,探讨怎么样使用ChatGPT。在最后的第四部分,我会介绍ChatGPT的最新发展。

2 ChatGPT原理简介

ChatGPT是一个基于Transformer架构的神经网络模型,也是GPT系列模型中的其中一员。其中“GPT”是“Generative Pre-trained Transformer”的缩写,中文意为通用预训练Transformer模型。“神经网络”顾名思义是一种借鉴了人类神经系统传递信号方式的数学模型。这一模型的基本单元模拟了神经细胞接收和产生电刺激的工作方式,并通过多个基本单元的连接模拟神经系统的工作。这一对人类思维的物质基础进行建模的尝试,带有着让模型完成人类能够胜任的任务的期望。也是我们今天看到的很有“人情味”的ChatGPT的基础。

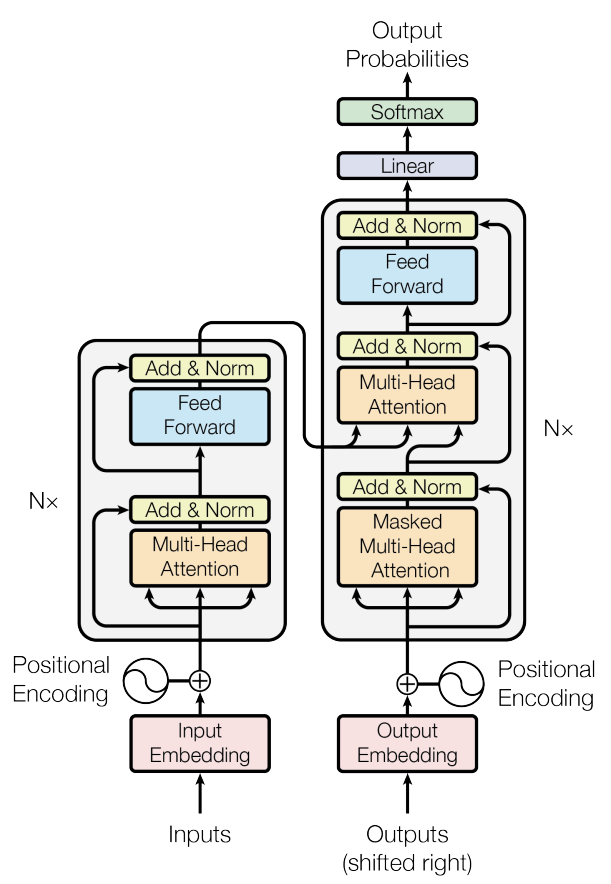

“GPT”中的“T”——Transformer架构就是一个经典的神经网络模型架构。整体结构上它主要由一个编码器(Encoder)部分和一个解码器(Decoder)部分组成,神经网络的结构则包含在编码器和解码器中。功能上,编码器负责将输入的文本转换为向量序列,解码器则负责根据编码器生成的向量序列生成输出文本的一部分(通常为一个单词)。当模型刚接收到一段文本并按上面所说的顺序生成了输出文本的第一部分后,模型会将新得到的这部分输出作为输入的一部分重复上面的两步骤过程,直到表示终止的符号生成或是输出内容超过了允许的最大长度。

图2 Transformer架构[1]

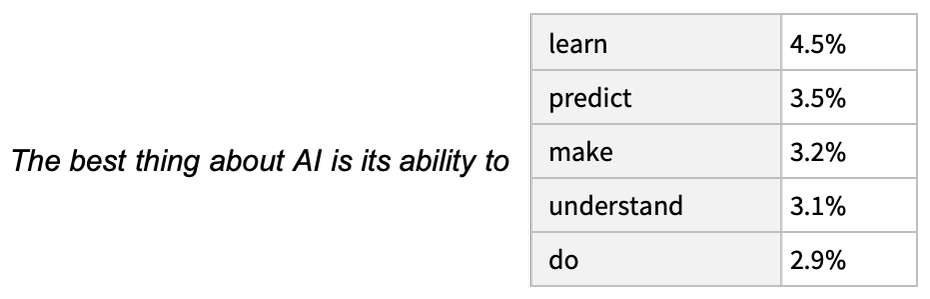

值得注意的是,Transformer模型是基于计算得到的概率来生成输出文本的。在得到一段输入文本后,Transformer模型会计算出所有单词各自在下一个位置出现的概率,而后带有随机性地在出现概率较高的单词中挑选一个作为输出。这种随机挑选的方式使得生成的文本具有了不确定性,但也正是这种不确定性的引入使得生成的文本具有了更多的多样性和创造性。

图3 Transformer模型输出方式[10]

GPT系列模型的设计初衷体现着OpenAI公司对通用人工智能的追求,是为了解决一系列的自然语言处理问题,这需要模型能够拥有很好的自然语言理解和生成能力。Transformer架构正拥有这方面的能力。除此之外,Transformer架构在并行计算上的优势也使得模型的大型化成为了可能。

而要使得模型能够完成自然语言处理的任务,首先需要对模型进行“Pre-train”(预训练),也就是让模型“学习”大量的语言材料。在这个学习的过程中,模型会调整内部的参数以使得自身的输出能够和所学习的语言材料有比较好的相似性。我们所看到的ChatGPT就是神经网络模型经过充分的学习和微调之后的成果。

3 OpenAI公司与GPT模型的发展

ChatGPT背后的OpenAI公司(以下称“OpenAI”)成立于2015年12月,总部位于美国旧金山。其创始人由多位科技领袖组成,包括山姆·阿尔特曼(Sam Altman)、埃隆·马斯克(Elon Musk)等。在创立之初,OpenAI为一家非盈利公司,其宗旨为“实现安全的通用人工智能”。 在其宗旨的指引下,OpenAI开展了包括有研发人工智能技术、开发维护开源工具和库、向企业提供人工智能服务等多项业务。现今,OpenAI公司的拳头产品共有三个,分别是主攻自然语言生成的GPT系列模型,可利用输入的自然语言文本生成图片的DALLE系列模型以及支持多语言语音识别Whisper模型。

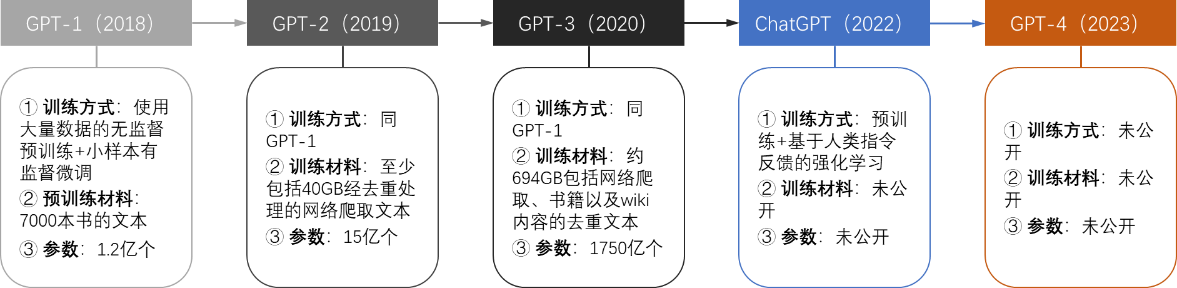

第一代GPT模型GPT-1诞生于2018年,它采用了Transformer架构中的解码器(Decoder)部分作为模型的基础架构。迄今为止,GPT的发展已经经历了四个大版本,按发布时间依次命名为GPT-1到GPT-4。根据已经公开的信息,GPT-1到GPT-3三代模型的结构基本相同,主要的变化在于模型结构内一些重复模块数量的增加。除此之外,在模型的迭代过程中,模型的训练方式在不断改进,训练用的语言资料数量与类型也在不断扩充。

图4 GPT系列模型的发展过程

随着GPT模型体量的逐代增大,GPT模型的参数数量由GPT-1的1.2亿个增加到了GPT-3的1750亿个。让人眼前一亮的是,像GPT-3这样具有千亿级别参数的 “大语言模型”出现了“涌现能力”。这是指当一些模型的参数规模达到一定程度之后,他们的性能出现了突然增长的现象。而这种涌现能力的出现也是ChatGPT展现出惊人表现的一个重要原因。

在最早的GPT-3模型基础上,“3.5版本”的ChatGPT采用了“基于人类指令反馈的强化学习”(Reinforcement Learning From Human,RLHF)对ChatGPT模型进行训练以使ChatGPT的输出能接近于人类的偏好和价值观。简单地说,这种训练方法会提供人类对一些问题的作答结果让ChatGPT进行学习,而后通过对完成学习的ChatGPT的输出结果给予评价反馈进一步引导ChatGPT调整自身。除了训练方式的改进以外,ChatGPT所学习的语言材料还加入了不同程序语言编写的代码,这使得ChatGPT具有了理解和输出代码的能力。

4 如何使用ChatGPT

作为一个语言模型,ChatGPT所能做的是理解和生成自然语言。在经过大量的语言资料训练后,ChatGPT的“大脑”记录下了这些资料中大量的知识。其中程序代码的引入还赋予了ChatGPT一定的推理能力。而后期有人类介入的微调则使得ChatGPT能够以接近人类的方式进行对话。这些能力使得ChatGPT成为了一个很好的咨询对象,你可以尝试用你最为熟悉的语言询问它各种各样的问题或是给它一些具体的任务,就像和一个真实的人对话一样,ChatGPT都会礼貌地给你一个至少看上去不错的解答。

一般应用ChatGPT的方式是直接在网页上通过对话框向他提问。比如你可以问他一些知识性的问题,让ChatGPT利用它的“知识库”为你提供答案。

图5 ChatGPT的知识服务

你还可以让ChatGPT发挥其序列转换的长处,让它完成一些自然语言翻译甚至是代码翻译的任务。

图6 ChatGPT代码翻译示例

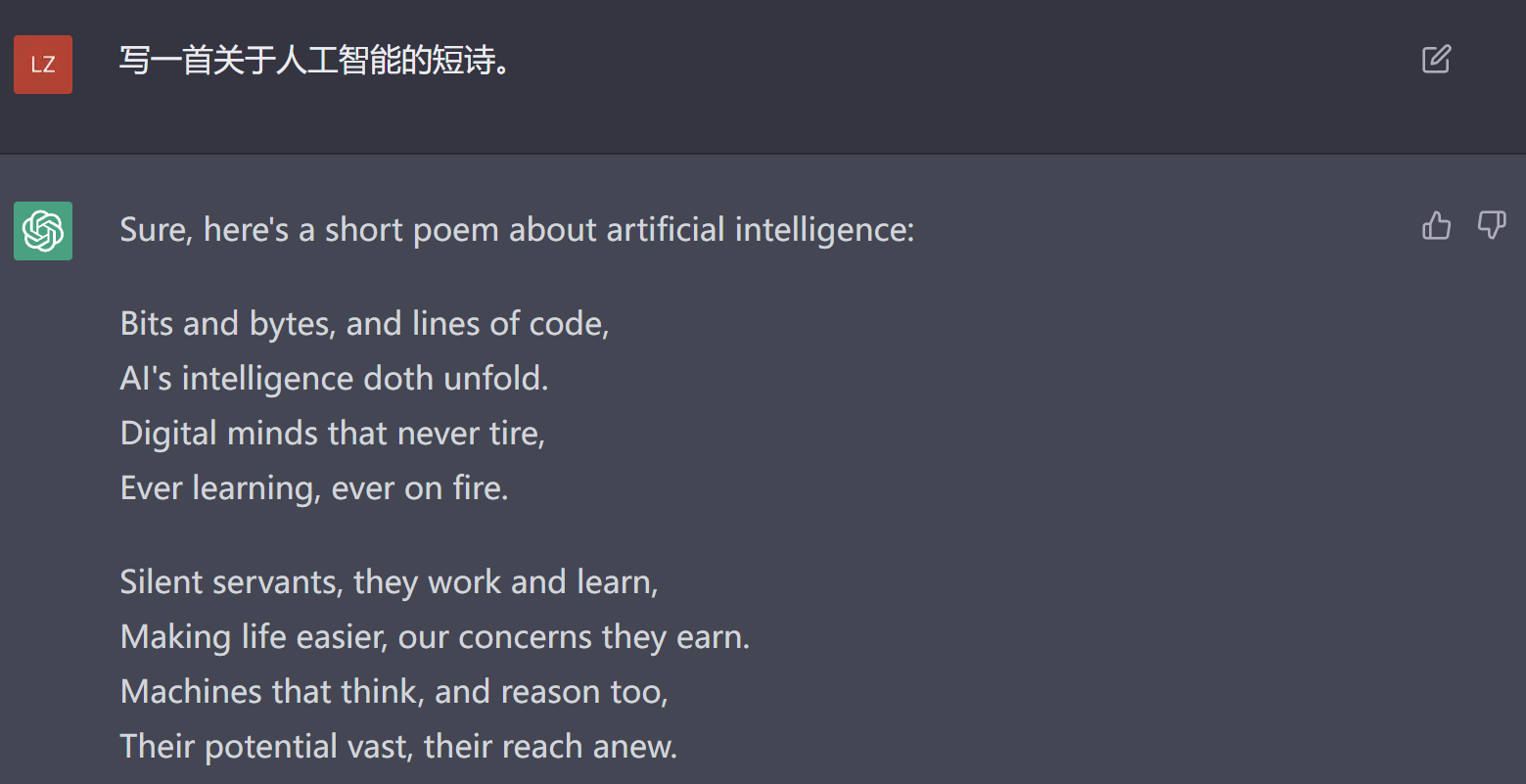

文本创作的任务对ChatGPT来说也不是一件难事。

图7 ChatGPT创作诗歌

具体的应用情景还有很多很多,网络上也有很多相关的介绍,在此就不再赘述了。而除了在网页上使用ChatGPT以外,利用代码调用ChatGPT的API也是一种可行的方式。在OpenAI的官网上,官方提供了API的使用说明以及数十种使用案例。用户可以方便地根据自己的需求进行使用。

ChatGPT的能力固然很强,但或许大家也注意到,ChatGPT的回答也并不总是那么令人满意,有的时候它甚至还会捏造事实或是生成具有偏向性的信息(比如提供不存在的期刊文章信息)。这也提醒我们要关注ChatGPT的局限性,从而可以更好地去使用它。为此,我总结了以下几点ChatGPT的局限性:

本质上ChatGPT是基于概率带有随机性地生成输出结果且结果无法溯源

知识库并非实时更新且无法联网,ChatGPT掌握的知识仅截止于2021年9月

无法从过去的对话中进行学习

回答一般秉持客观公正的态度,但回答的内容受训练语料影响,存在带有偏向性的可能

解决数学问题的能力一般

只能生成纯文本,无法绘图

因此,了解到ChatGPT能力的有限性,我们应该让它完成它力所能及的任务。对ChatGPT提供的答案,我们也需要进一步地去推敲和验证。当然,在一些像了解概念、搜集信息这样简单的任务上,ChatGPT不失为一个足够好的工具。对于一些复杂的问题,我们也可以尝试将其拆分为多个小问题,利用ChatGPT的推理能力将其逐步解决。而也像在真实生活中和其他人沟通一样,准确和全面地描述我们的问题能够让ChatGPT更好地理解我们所要传达的信息,从而让我们得到一个更有针对性的答案。最后,上面所叙述的方法更多的是概念而非一些可以直接操作的流程,究竟要怎么找到适合自己的ChatGPT使用方法,还需要大家自己多去“拷打”ChatGPT。

5 ChatGPT的最新发展

技术发展的速度让人感到惊讶,ChatGPT诞生4个月未到,它已经完成了多次更新并应用到了多个其他领域的产品中。今年3月15日凌晨,OpenAI发布了新一代的GPT——GPT-4。根据OpenAI的报告,GPT-4表现出了比3.5版本的ChatGPT更强的实力。一个显著的突破是基于GPT-4版本的ChatGPT开始支持图片输入并且它可以理解图片中的内容(技术路线未公开并且未向用户开放)。而在ChatGPT的强项——自然语言处理上,GPT-4版本的模型也有进步。比如在并未进行针对性训练的情况下,GPT-4版本的ChatGPT就拿到了美国法考(Uniform Bar Exam)模拟考排名前10%的好成绩,而上一代的ChatGPT排名仅在后10%。OpenAI还进行了许多模拟针对人类设计考试的测试,结果表明GPT-4的表现在大部分考试中都要显著优于其他最先进的语言模型(甚至包括为考试做了针对训练的模型)以及它自身的上一代版本。

图8 GPT-4对图片的理解[6]

图9 GPT-4与GPT-3.5的测试成绩对比[6]

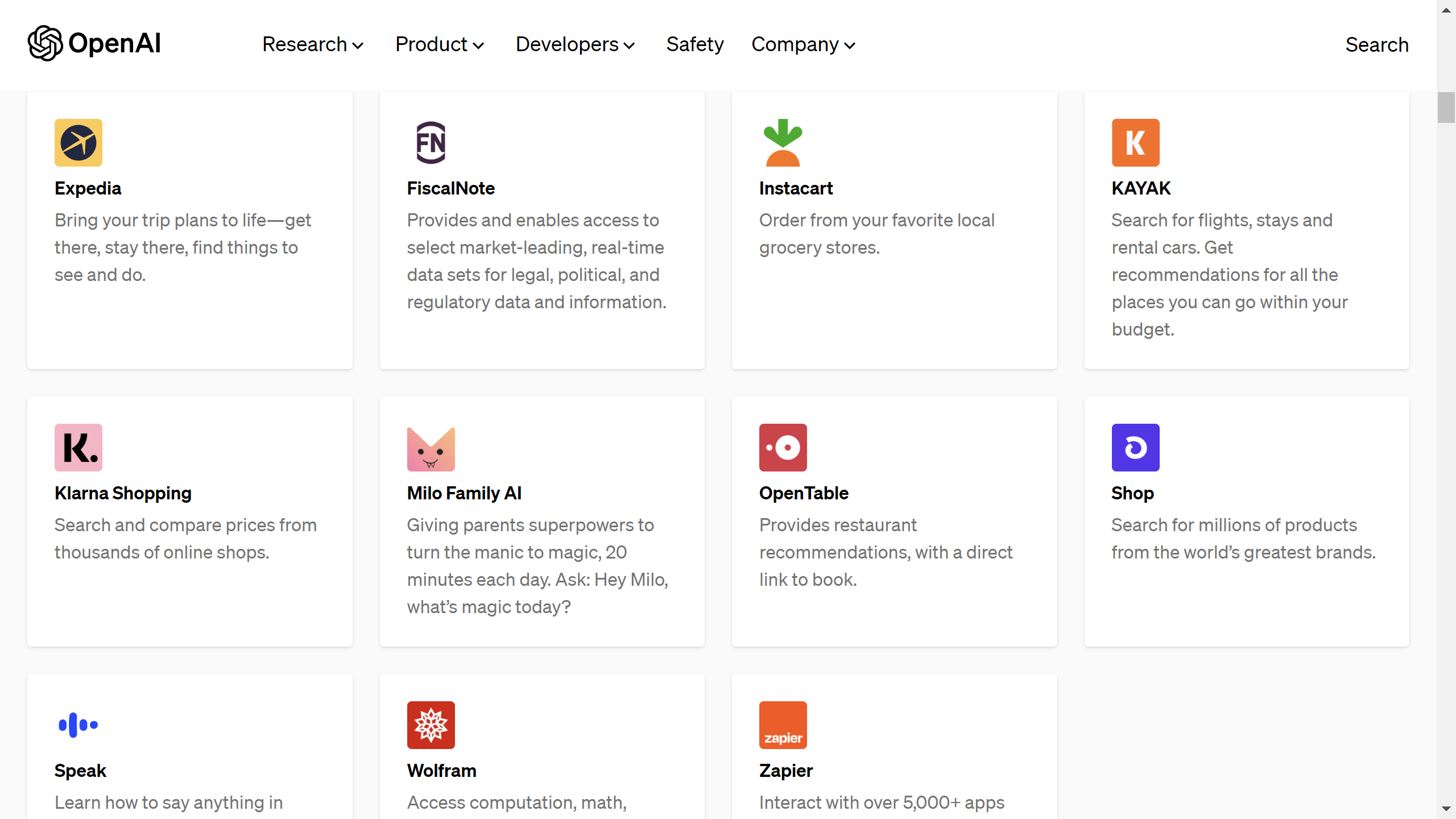

而随后在今年3月24日凌晨,OpenAI宣布推出ChatGPT的插件功能,使ChatGPT能接入一些外部的工具以拓展其功能。OpenAI自己开发了两个插件,分别是网页浏览器(Web Browser)和代码解释器(Code Interpreter)。前者可以让ChatGPT接入互联网获取信息,后者支持在对话的过程中运行代码以完成用户的一些任务,或是接收用户上传的文件并按用户的要求对文件进行处理。OpenAI还开源了一个检索插件(Retrieval),利用这个开源插件用户可以调用个人的数据并利用ChatGPT强大的文本理解能力对数据进行处理。

除了官方的插件以外,OpenAI还罗列出了多个第三方的插件,如擅长数学计算的Wolfram插件、可以规划旅游行程的Expedia插件、帮你找心仪超市的Instacart插件等。这些插件基于ChatGPT的自然语言理解和处理能力为ChatGPT在应用层面做了很大的拓展。用OpenAI自己的话说,它们就像是ChatGPT模型的“眼睛和耳朵”,使ChatGPT能够获取实时、个人化的数据并更好地回应用户的请求。

图10 ChatGPT支持的第三方插件[13]

除了自身的发展以外,GPT系列模型还与其他的一些产品进行了结合,其中最为引人注目的有微软公司的Bing搜索引擎以及微软公司的Office系列办公软件。与GPT结合的Bing引擎被称作New Bing,发布于今年的2月7日。二者的结合使得Bing拥有了和ChatGPT相同的对话功能,同时这种对话模式与搜索功能相结合的形式也使得在互联网检索内容这一交互过程变得更加的人性化。

在今年的3月17日,也就是GPT-4发布两天不到,微软就发布了Copilot——一个使用GPT-4模型的Microsoft 365办公软件助手。在微软的宣传中,Copilot将能利用Microsoft 365中的用户数据,在文本撰写、PPT制作、Excel数据分析等方面为用户提供一些创造性的建议;在总结报告内容、总结Team会议等方面节省用户的时间;并且能让用户以自然语言的方式调用软件中的各种功能函数,降低了软件的使用门槛。试想一下以往要花费数个小时准备的一份PPT现在只需要提供一份文档并按下按钮就可以马上完成,未来的工作模式可能已经在此刻悄然发生改变。

但GPT还远不是完美的,GPT涌现出一些能力的机理也尚不明晰,对这样一个强大而又有些陌生的新生事物,我们希望它能为我们的生活注入新的动力,但也害怕它带来一些不可预知的混乱。在确保模型安全性这方面,OpenAI已经做了很多的工作,比如让各领域的专家测试模型可能存在的风险、用基于人类反馈的强化学习规范模型的行为、监测对模型的不当使用行为等。尽管如此,对GPT模型本身的行为规范也仍只是在“进行中”,而GPT模型对社会经济的影响可能还是一个更为复杂和困难的问题。

最近生命未来研究所(Future of Life Institute)这一组织的官网发布了一封题为《暂停大型AI实验》的公开信,信中表达了对当下AI发展如“失控般”的竞赛的担忧并征集到了许多业界大牛的签名支持。我们无法得知这封信出现的全部目的,但至少我们可以看到除了追求技术的进步以外还有很多技术以外的问题需要我们去认真考虑。

6 结语

作为一个新生事物,ChatGPT仍在不断发展的过程中,本文尽可能全面地介绍了与ChatGPT有关的种种,但也难以囊括其发展的全部与最新进展。希望本文能给想要了解ChatGPT的读者一些帮助与启示,也希望中国的“ChatGPT”能够早日诞生。

7 参考文献

[1] Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need[J]. Advances in neural information processing systems, 2017, 30.

[2] Radford A, Narasimhan K, Salimans T, et al. Improving language understanding by generative pre-training[J]. 2018.

[3] Radford A, Wu J, Child R, et al. Language models are unsupervised multitask learners[J]. OpenAI blog, 2019, 1(8): 9.

[4] Brown T, Mann B, Ryder N, et al. Language models are few-shot learners[J]. Advances in neural information processing systems, 2020, 33: 1877-1901.

[5] Ouyang L, Wu J, Jiang X, et al. Training language models to follow instructions with human feedback[J]. arXiv preprint arXiv:2203.02155, 2022.

[6] OpenAI. GPT-4 Technical Report[J]. arXiv preprint arXiv: 2303.08774, 2023.

[7] Sébastien Bubeck, Varun Chandrasekaran, Ronen Eldan, et al. Sparks of Artificial General Intelligence: Early experiments with GPT-4[J]. arXiv preprint arXiv:2303.12712v3, 2023.

[8] Yao Fu, Hao Peng, Tushar Khot. How does GPT Obtain its Ability? Tracing Emergent Abilities of Language Models to their Sources[EB/OL]. (2023-01-01)[2023-04-02]. https://yaofu.notion.site/How-does-GPT-Obtain-its-Ability-Tracing-Emergent-Abilities-of-Language-Models-to-their-Sources-b9a57ac0fcf74f30a1ab9e3e36fa1dc1

[9] Stephen Wolfram. Wolfram|Alpha as the Way to Bring Computational Knowledge Superpowers to ChatGPT[EB/OL]. (2023-01-09)[2023-04-02]. https://writings.stephenwolfram.com/2023/01/wolframalpha-as-the-way-to-bring-computational-knowledge-superpowers-to-chatgpt/

[10] Stephen Wolfram. What Is ChatGPT Doing … and Why Does It Work? [EB/OL]. (2023-02-14)[2023-04-02]. https://writings.stephenwolfram.com/2023/02/what-is-chatgpt-doing-and-why-does-it-work/

[11] Yusuf Mehdi. Reinventing search with a new AI-powered Microsoft Bing and Edge, your copilot for the web[EB/OL]. (2023-02-07)[2023-04-02]. https://blogs.microsoft.com/blog/2023/02/07/reinventing-search-with-a-new-ai-powered-microsoft-bing-and-edge-your-copilot-for-the-web/

[12] Jared Spataro. Introducing Microsoft 365 Copilot – your copilot for work[EB/OL]. (2023-03-16)[2023-04-02]. https://blogs.microsoft.com/blog/2023/03/16/introducing-microsoft-365-copilot-your-copilot-for-work/

[13] OpenAI. ChatGPT plugins[EB/OL]. (2023-03-23)[2023-04-02]. https://openai.com/blog/chatgpt-plugins

[14] Future of Life Institute. Pause Giant AI Experiments: An Open Letter[EB/OL]. (2023-03-29)[2023-04-02]. https://futureoflife.org/open-letter/pause-giant-ai-experiments